رباتها عنصر اجتناب ناپذیر دنیای دیجیتال امروزی هستند و تقریبا نیمی از ترافیک وب را تشکیل میدهند. رباتها در سراسر اینترنت میخزند و وب سایتها را به روشهای مختلف تحت تاثیر قرار میدهند. برخی از رباتها توسط صاحبان وب سایت به نفع خود استفاده میشوند، در حالی که برخی دیگر مخرب هستند که باید به هر قیمتی از آنها جلوگیری کرد. در این مطلب با ترافیک ربات آشنا خواهیم شد.

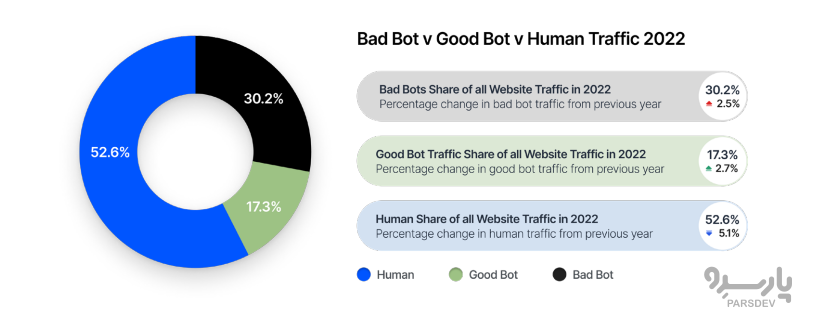

طبق گزارش Imperva 2022، بیش از ۴۷ درصد از ترافیک اینترنت شامل رفتار یا فعالیتهای غیرانسانی است که شامل برنامههای ترافیکی ربات از خزندههای معتبر گرفته تا نرم افزارهای فاسد میشود. این گزارش تاکید می کند که ترافیک بد ربات تقریبا دو برابر رباتهای خوب است.

قبل از اینکه به سراغ انواع مختلف رباتها و روشهای توقف ترافیک آنها برویم، اجازه دهید با رباتها و ترافیک رباتها آشنا شویم.

ربات و ترافیک ربات چیست؟

بات (Bot) معمولا مخفف Robots است که به عنوان رباتهای اینترنتی نیز شناخته میشوند. برنامههای کامپیوتری که برای خودکارسازی رفتار انسان طراحی شدهاند. رباتها برای شبیهسازی فعالیتهای انسانی و تقلید از آن بدون ورودی خارجی برنامهریزی شدهاند. آنها می توانند کارهای روزمره و تکراری را به سرعت و کارآمد انجام دهند و آنها را به یک گزینه عملی تبدیل کند.

اصطلاح ترافیک ربات به ترافیک غیر انسانی در وب سایت یا برنامه اشاره دارد. اگرچه ترافیک ربات در اینترنت کاملا عادی است، اما معمولا مفهوم منفی دارد. اما وجود رباتهای خوب را نباید نفی کرد، این بستگی به قصد سازنده دارد که ربات را برای چه هدفی بسازد.

در عصر دیجیتال، رباتها تقریبا در همه حوزهها مشهود هستند و برای اهداف متعدد استفاده میشوند. رباتهای موتور جستجو و دستیارهای دیجیتال ضروری مانند Alex و Siri وجود دارند که رباتهای خوبی در نظر گرفته میشوند.

از سوی دیگر، ربات های مخرب برای حملات DDoS، دیتا اسکرپینگ و سایر فعالیت های شرور استفاده میشوند. بنابراین، دو فعالیت ربات مختلف وجود دارد، خوب و بد. در ادامه مطلب جزئیات بیشتری در مورد هر دسته ارائه شده است.

ترافیک ربات خوب چیست؟

رباتهای “خوب” هیچ آسیبی به وب سایت وارد نمیکنند. این ترافیک غیر انسانی به شما امکان میدهد از حضور و فعالیت آنها در صفحه خود مطلع شوید. بسیاری از مردم از این رباتهای پیشرفته برای سهولت در کار روزمره خود استفاده میکنند. چنین رباتهای خودکار کارهای تکراری زیادی را برای صاحبان وبسایت هندل میکنند و به آنها کمک میکنند چندین کار را به سرعت و کارآمد مدیریت کنند.

اگرچه رباتهای اینترنتی به خاطر اشتباهات خود بدنام هستند، برخی از رباتهای قانونی به جای ایجاد مشکل به ترافیک وبسایت کمک میکنند. برخی از ربات های معروف “خوب” عبارتند از:

-

رباتهای موتور جستجو

خزندههای ضروری موتورهای جستجو هستند که به کشف محتوا در وب کمک میکنند. وقتی چیزی را جستجو میکنید، رباتها وب سایت شما را می خزند تا محتوا را پیدا کرده و اطلاعات مورد نیاز را ارائه دهند. بنابراین، داشتن این رباتها ترافیک خوبی برای وب سایت شما است.

-

رباتهای تجاری

ربات هایی هستند که توسط شرکتهای تجاری برای منافع خود استفاده میشوند. آنها این رباتها را برای خزیدن در اینترنت و جمع آوری اطلاعات لازم ارسال می کنند.

به عنوان مثال، شبکههای تبلیغات آنلاین از ربات تجاری برای بهینه سازی تبلیغات نمایشی استفاده میکنند. شرکتهای تحقیقاتی از رباتهای تجاری تحقیقاتی برای نظارت بر اخبار بازار و غیره استفاده میکنند.

-

خزندههای سئو (SEO crawlers)

کسانی که با سئو آشنایی دارند باید از ابزارهایی مانند Ahrefs و Semrush برای جستجوی کلمات کلیدی و کارهای دیگر استفاده کرده باشند. این ابزارها رباتهایی را برای خزیدن در وب و جمعآوری اطلاعات بر اساس نیازهای شما ارسال میکنند.

-

رباتهای مانیتورینگ

این رباتهای پیچیده به نظارت بر معیارهای وبسایت مانند زمان کار، نرخ پرش و غیره کمک میکنند. آنها با بررسی دورهای و گزارش دادههای مختلف، شما را در مورد وضعیت سرور و وبسایت بهروز میکنند. این به شما کمک می کند تا وب سایت خود را پیگیری کنید و در صورت بروز هرگونه نقصی اقدام کنید.

-

رباتهای کپی رایت

این رباتها وب را اسکن میکنند تا مطمئن شوند که محتوا یا تصاویر شما بهطور غیرقانونی دزدیده نشدهاند. ردیابی یک تصویر دزدیده شده در چنین وب گستردهای بسیار چالش برانگیز است. بنابراین، ربات به خودکارسازی کار و محافظت از محتوای دارای حق چاپ شما کمک میکند.

ترافیک بد ربات چیست؟

رباتهای اسپم یک منظره رایج در چندین وب سایت هستند. رباتهای بدی هستند که برخلاف رباتهای واقعی با نیتهای بد ایجاد شدهاند. آنها اغلب به عنوان نظرات بیمعنی یا رباتهایی مبدل میشوند که تمام صندلیهای خوب یک کنسرت را میخرند. آنها می توانند به شکل تبلیغات ظالمانه و بک لینکهای نامربوط باشند.

این رباتهای مخرب دلیل بدنامی رباتهای اینترنتی هستند. آنها به میزان قابل توجهی در سراسر وب حضور دارند و برای کاربران دردسر ایجاد می کنند. برخی از ترافیک ربات های مخرب برجسته که باید از آنها جلوگیری کرد عبارتند از:

-

اسکریپر (Scrapers)

این رباتهای بد مزاحم وبسایتها را خراش میدهند و هر اطلاعات ارزشمندی را که میتوانند دریافت کنند، دانلود میکنند، از جمله محتوا، فایلها، تصاویر،فیلمها و غیره. صاحبان وبسایتهایی که از این ربات استفاده میکنند، بدون اجازه از دادههای دزدیده شده در وبسایت خود استفاده میکنند. اسکریپرها همچنین آدرس های ایمیل و سایر اطلاعات تماس را برای ارسال ایمیلهای مخرب جمع آوری میکنند.

-

رباتهای اسپم

گاهی اوقات، نظرات عجیب و غریبی را در ایمیل یا وبلاگ خود توسط یک غریبه مشاهده میکنید. ربات اسپم این کار را انجام میدهد. آنها چند چهره دارند و میتوان آنها را به عنوان رباتهای پرکننده فرم مشاهده کرد که فرمهای تماس را در وب سایت پر میکنند، ربات های ترافیک اسپم که وب سایت شما را با تبلیغات و سایر لینکهای نامناسب اسپم میکنند و غیره.

-

رباتهای DDoS

از قدیمی ترین و کشنده ترین رباتها هستند. DDoS به رباتهای Distributed Denial of Service اشاره دارد. شبکههای مختلفی از دستگاه های آلوده مانند بات نتها برای انجام حملات DDoS استفاده میشوند.

هنگامی که یک ربات DDoS روی کامپیوتر نصب میشود، وب سایت یا سرور خاصی را هدف قرار میدهد تا آن را از کار بیندازد. این رباتهای بد با تاثیر بر سرعت و عملکرد آنها از نظر مالی به آن سایتها آسیب میرسانند. در نتیجه کل وب سایت را آفلاین میکنند.

-

رباتهای کلاهبرداری کلیکی(Click fraud bots)

از صاحبان سایتهای مختلف به دلیل وجود این ربات های مخرب هزینههای تبلیغاتی زیادی دریافت میشود. رباتهای کلاهبرداری تبلیغاتی روی تبلیغات کلیکی (PPC) کلیک می کنند تا درآمد بیشتری ایجاد کنند. ربات به صورت مبدل برای کاربران قانونی روی تبلیغ کلیک میکند. این فعالیت ربات منجر به صرف بیش از حد بودجه تبلیغاتی میشود زیرا باعث کلیک روی تبلیغات جعلی در وب سایت میشود.

-

رباتهای حمله Brute Force

ترافیک ربات در وب سایت شما خود را به سرور وارد میکند. این رباتها بهعنوان کاربران واقعی به صورت پوشیده وارد وبسایت شما میشوند و قصد سرقت دادههای حساس را دارند. این رباتهای مخرب به اپراتور خود گزارش میدهند، که سپس اطلاعات را به نفع خود میفروشد یا استفاده میکند.

سرور مجازی لینوکس یک ماشین مجازی کامل است که امکان دسترسی SSH طبق آموزش را به آن خواهید داشت.

خرید سرور مجازی لینوکس در پنج موقعیت جغرافیایی ایران، ترکیه، هلند، آلمان و آمریکا با قابلیت تحویل آنی در پارسدو فراهم است.

چگونه ترافیک ربات را تشخیص دهیم؟

ربات های خزنده موتورهای جستجو به سرعت در حال کنترل بر روی وب هستند. در حالی که برخی از آنها مفید هستند، ترافیک رباتهای مخرب به دادههای تحلیلی وب سایت شما با تاثیر بر معیارهای سایت آسیب میزند.

بنابراین، شناسایی ترافیک ربات در وب سایت خود و حذف این ترافیک ناخواسته بسیار مهم است. مهندسان وب و ارائه دهندگان وب مانند سرور VPS می توانند مستقیم به درخواستهای شبکه به وبسایت خود برای شناسایی ترافیک ربات نگاه کنند.

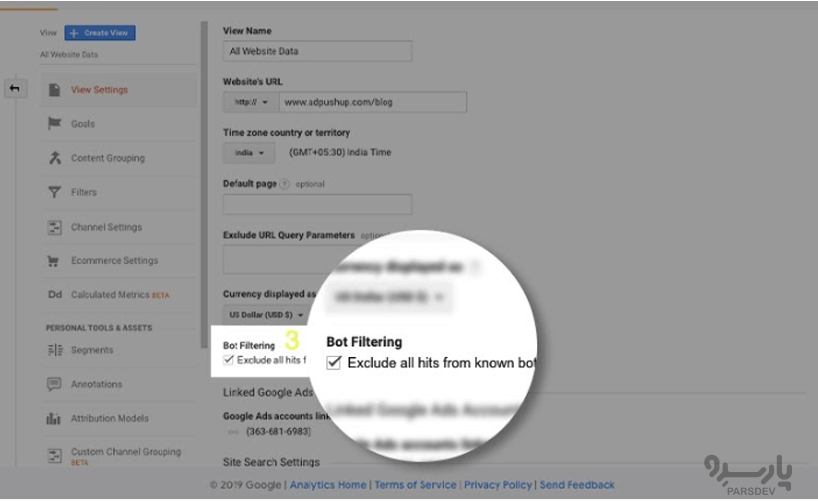

گوگل آنالیتیکس یکی از بهترین ابزارها برای شناسایی ترافیک رباتها در یک وب سایت است. حساب Google Analytics حاوی یک کادر انتخاب Bot Filtering است که به فیلتر کردن ترافیک ربات در سرور کمک میکند. ناهنجاری های زیر در داده های تجزیه و تحلیل گوگل با نشان دادن وجود رباتهای ترافیک وب سایت به شناسایی ترافیک ربات کمک می کند:

-

بازدیدهای غیرمعمول صفحه از یک آدرس IP واحد

یک وب سایت عمومی باز باید بسته به موقعیت مکانی، پایگاه مشتری و سایر عوامل، از چندین آدرس IP بازدید داشته باشد. با این حال، اگر ترافیک بالایی را از یک منبع غیرمنتظره یا یک آدرس IP منفرد جذب کند، این نشانه واضحی از ترافیک ربات است.

مکان آدرس IP نیز می تواند یک عامل قضاوتی باشد، زیرا یک وب سایت با محتوای ژاپنی که حجم بالایی از بازدید از یک آدرس IP مستقر در روسیه دارد، یک پرچم قرمز است.

-

نرخ پرش غیرمنتظره بالا (bounce rate)

نرخ پرش به زمانی اشاره دارد که یک بازدیدکننده در صفحه شما صرف میکند. درصدی از ترافیک وب به یک وب سایت است که در عرض چند ثانیه از صفحه خارج میشود یا صفحه را ترک می کند. دادههای تحلیلی که نرخ پرش یک وب سایت را بیان میکند نیز میتواند نشانگر ترافیک ربات باشد.

هر گونه الگوی غیرعادی در این معیار، مانند جهش ناگهانی یا کاهش درصد نرخ پرش بدون توضیح منطقی، می تواند کار ربات باشد.

-

افزایش ناگهانی بازدید از صفحه

افزایش غیرمنتظره تعداد بازدیدهای صفحه، حتی اگر معقول به نظر برسند، میتواند باعث نگرانی شود. گاهی اوقات، وب سایت شما توسط بازدیدکنندگان طبیعی از مکانها و آدرسهای IP مختلف مشاهده میشود، اما ترافیک ربات است. بررسی دادههای تجزیه و تحلیل Google میتواند به شما کمک کند تا مطمئن شوید که افزایش ناگهانی ترافیک طبیعی است یا به دلیل DDoS

-

تبدیلهای جعلی (Fake conversions)

برخی از رباتها برای افزایش تبدیل های ساختگی در یک وب سایت طراحی شدهاند. شامل رباتهای احتکار موجودی میشوند که با ارسال فرمهای جعلی، سبدهای جعلی را در یک وبسایت تجارت الکترونیکی بدون بررسی هیچیک از موارد یا افزایش اشتراک خبرنامه تولید میکنند.

این ربات ها با استفاده از نام های عجیب و غریب، آدرس های ایمیل و اطلاعات تماس، حسابهای جعلی ایجاد میکنند. افزایش غیرقابل پیشبینی در تبدیلها بدون هیچ دلیل خاصی میتواند نشان دهنده ترافیک جعلی به یک وبسایت و تبدیلهای ناخواسته ایجاد شده توسط این رباتها باشد.

-

ارجاع دهنده شبکههای اجتماعی (Social media referrer)

ترافیک ربات همچنین می تواند صفحات رسانههای اجتماعی شما را بخزد. رباتهای ترافیک ارجاعی از ارجاعدهنده معمولی تقلید میکنند که منبع ترافیک جدید به یک وبسایت را اعلام میکند. اینها همچنین می توانند شبیه کاربران واقعی به نظر برسند اما ترافیک ربات هستند.

برخی از علائم دیگر برای شناسایی ربات هایی که سیستم شما را آلوده می کنند عبارتند از:

- خرابیهای مکرر یا اشکالات نرم افزاری.

- عوامل غیر منطقی باعث کاهش سرعت بارگذاری صفحه یا سرعت اتصال به اینترنت میشود.

- گوگل یا سایر موتورهای جستجو ویژگی@هایی را نشان میدهند که کاربر نصب نکرده است.

- پاپ آپ ناشناخته ظاهر میشود و برنامهها بدون اطلاع کاربران اجرا میشوند.

چگونه ترافیک ربات را متوقف کنیم؟

هنگامی که میدانید چگونه ترافیک ربات را شناسایی کنید، باید راه هایی برای جلوگیری از حملات ربات به سیستم خود بیابید. اگرچه نیاز اساسی این است که از آسیب رساندن ترافیک ربات بد به وب سایت یا سرور خود جلوگیری کنید، باید ترافیک رباتهای خوب و تجاری را نیز مدیریت کنید. رباتهای خوب همیشه برای سایت مفید نیستند زیرا میتوانند ترافیک اینترنت را تحت فشار قرار دهند و بر عملکرد سایت تاثیر بگذارند. علاوه بر این، مدیریت ترافیک ربات میتواند به تفکیک رباتهای خوب و بد کمک کند.

به همین ترتیب، ترافیک غیرمجاز ربات به یک وب سایت نیز متفاوت است. همان ربات مخرب همه سایتها را آلوده نمی کند. دلایل و روشهای مختلفی وجود دارد که از طریق آن ربات بد به یک وبسایت حمله میکند، بنابراین هیچ راهحل استاندارد مدیریت ربات وجود ندارد که برای همه مناسب باشد.

می توانید اقدامات پیشگیرانه ای برای جلوگیری از آلوده کردن ربات های مخرب سیستم خود انجام دهید. در اینجا چند ابزار و مراحل تشخیص ربات برای مدیریت ربات های خوب و بد آورده شده است.

شما می توانید چندین کار انجام دهید تا ربات بد سیستم شما را تحت فشار نگذارند. بعضی از آنها هستند:

-

منبع را مسدود کنید

یکی از اساسی ترین راهها برای جلوگیری از ترافیک ناخواسته ربات، مسدود کردن منبع ترافیک اینترنت است. میتواند یک بازدیدکننده فردی یا طیف وسیعی از آدرسهای IP باشد که ترافیک نامنظم را منعکس میکند. همچنین می توانید از راه حلهای مدیریت ربات از ارائه دهندگان مختلف برای جلوگیری از ترافیک ربات استفاده کنید. آنها رباتهای مخرب را شناسایی کرده و با استفاده از هوش مصنوعی و یادگیری ماشین، قبل از اینکه آسیبی وارد کنند، آنها را مسدود میکنند.

-

رباتهای مانیتورینگ

با نظارت بر آنها، ربات های مخرب و فعالیت های غیرعادی آنها در سایت خود را بهتر درک میکنید. یک خط پایه از رفتار معمول انسان ایجاد کنید که می توانید از آن برای جستجو و مقایسه هر گونه فعالیت نامنظم در سایت استفاده کنید. پاسخهای خودکاری را برطرف کنید که باعث ایجاد زنگ هشدار میشوند و بازدیدکنندگانی را که از آستانه انسانی فراتر میروند مسدود میکنند.

-

افزونه امنیتی را نصب کنید

راه دیگر برای جلوگیری از ترافیک بد ربات، نصب یک افزونه امنیتی است. اگر وب سایت شما بر روی وردپرس ساخته شده است، می توانید افزونه های امنیتی مانند Wordfence یا Sucuri Security را نصب کنید. اینها توسط شرکتهایی مدیریت میشوند که محققان امنیتی مستمر مسائل را نظارت و اصلاح میکنند.

در حالی که برخی از افزونههای امنیتی دارای ویژگیهای خودکار برای مسدود کردن رباتها هستند، برخی دیگر به شما اجازه میدهند منبع ترافیک غیرعادی را ببینید و تصمیم بگیرید که چگونه با چنین ترافیک اینترنتی مقابله کنید.

چگونه رباتهای خوب را متوقف کنیم؟

گاهی اوقات، کنترل رباتهای خوب برای حفظ ترافیک ربات در وب سایت ضروری می شود. برخی از مراحلی که می تواند به مدیریت آنها کمک کند عبارتند از:

مسدود کردن رباتهایی که مفید نیستند

همه ربات های “خوب” برای وب سایت شما مفید نیستند. شما باید تصمیم بگیرید که آیا این رباتها برای سایت شما مفید هستند یا خیر. به عنوان مثال، به غیر از گوگل، سایر ربات های موتور جستجو اغلب در روز صدها بار در وب سایت شما می خزند، اما بازدیدکنندگان زیادی را به همراه ندارند. بنابراین، مسدود کردن ترافیک ربات از آن موتورهای جستجو عاقلانه تر است.

-

سرعت خزیدن ربات را محدود کنید

محدود کردن نرخ خزیدن، رباتها را از بازگشت مکرر یا خزیدن روی لینکهای مشابه محدود میکند. با استفاده از Crawl-delay در robots.txt، می توانید نرخ خزیدن رباتهای مختلف را تنظیم کنید. میتوانید نرخ تاخیر خاصی را برای خزندههای مختلف تعیین کنید. متاسفانه گوگل از تاخیر خزیدن پشتیبانی نمیکند. اما میتوانید از این قابلیت برای سایر موتورهای جستجو استفاده کنید.

-

لیستها را مسدود و مجاز کنید

هنگامی که یک راه حل مناسب برای شناسایی و مدیریت ربات دارید، باید یک بلوک و لیست مجوز را تنظیم کنید. “لیست مجاز” شامل ربات های خوبی است که به آنها اجازه می دهید در وب سایت شما پرسه بزنند. اینها ربات هایی هستند که کاملا مطمئن هستید برای سایت شما مفید هستند. همچنین میتوانید ترافیک رباتهای خوب را با استفاده از قابلیتهای تایمباکس یا محدودکننده نرخ، مدیریت کنید تا به شرایط خود دسترسی داشته باشید.

نتیجه گیری

برای هر وب سایت، میزان ترافیک ربات، ترافیک غیر انسانی است که تجربه میکند. اگرچه ترافیک ربات مزایای خاص خود را دارد، وب سایت باید بتواند ترافیک رباتهای خوب و بد را برای مدیریت عملکرد شناسایی کند. تهیه خدمات یک میزبان وب مناسب مانند سرور VPS می تواند به شناسایی انواع مختلف ترافیک ربات در وب سایت کمک کند.

علائم زیادی برای بررسی ترافیک رباتهای مخرب وجود دارد که به وب سایت یا سرور آسیب میرساند. هنگامی که ربات اینترنتی از وب سایت بازدید کند، میتوان تصمیم گرفت که آیا ترافیک ربات بد بوده یا مفید است. در نتیجه، میتوانید تعیین کنید که چه کاری باید با آن انجام شود.

اگر اقدامات مناسب را بدانید، مقابله با ترافیک ربات آسان است. Google Analytics یکی از ابزارهایی است که میتواند به شما در مدیریت ترافیک ربات کمک کند.